\

\

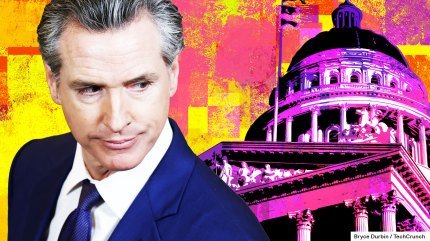

Um projeto de lei controverso da Califórnia para prevenir desastres de IA, SB 1047, foi aprovado nas votações finais no Senado do estado e agora segue para a mesa do Governador Gavin Newsom. Ele deve pesar os riscos teóricos mais extremos dos sistemas de IA - incluindo seu potencial papel em mortes humanas - contra a possibilidade de impedir o auge da IA na Califórnia. Ele tem até 30 de setembro para assinar o SB 1047 em lei, ou vetá-lo completamente.

\Apresentado pelo senador estadual Scott Wiener, o SB 1047 visa prevenir a possibilidade de modelos de IA muito grandes criarem eventos catastróficos, como perda de vidas ou ataques cibernéticos que custem mais de US$ 500 milhões em danos.

\Para ser claro, hoje existem muito poucos modelos de IA grandes o suficiente para serem cobertos pelo projeto de lei, e a IA nunca foi usada em um ataque cibernético dessa escala. Mas o projeto de lei se preocupa com o futuro dos modelos de IA, não com os problemas que existem hoje.

\O SB 1047 tornaria os desenvolvedores de modelos de IA responsáveis por seus danos - assim como tornar os fabricantes de armas responsáveis por tiroteios em massa - e concederia ao procurador-geral da Califórnia o poder de processar empresas de IA por pesadas multas se sua tecnologia fosse usada em um evento catastrófico. No caso de uma empresa agir de forma inconsequente, um tribunal pode ordenar que pare suas operações; os modelos cobertos também devem ter um "interruptor de desligamento" que permita que eles sejam desligados se forem considerados perigosos.

\O projeto de lei poderia remodelar a indústria de IA dos Estados Unidos, e está a uma assinatura de se tornar lei. Veja como o futuro do SB 1047 pode se desenrolar.

\Por que Newsom pode assiná-lo

\Wiener argumenta que o Vale do Silício precisa de mais responsabilidade, dizendo anteriormente ao TechCrunch que a América deve aprender com seus fracassos passados na regulamentação da tecnologia. Newsom poderia ser motivado a agir decisivamente na regulamentação de IA e responsabilizar as Big Tech.

\Alguns executivos de IA surgiram como cautelosamente otimistas em relação ao SB 1047, incluindo Elon Musk.

\Outro otimista cauteloso em relação ao SB 1047 é a ex-chefe de IA da Microsoft, Sophia Velastegui. Ela disse ao TechCrunch que "o SB 1047 é um bom compromisso", embora admita que o projeto de lei não seja perfeito. "Acho que precisamos de um escritório de IA responsável para a América, ou qualquer país que trabalhe nisso. Não deve ser apenas a Microsoft," disse Velastegui.

\A Anthropic é outra defensora cautelosa do SB 1047, embora a empresa não tenha adotado uma posição oficial em relação ao projeto de lei. Várias das alterações sugeridas pela startup foram adicionadas ao SB 1047, e o CEO Dario Amodei agora diz em uma carta ao governador da Califórnia que os "benefícios provavelmente superam os custos" do projeto de lei. Graças às emendas da Anthropic, as empresas de IA só podem ser processadas depois que seus modelos de IA causarem algum dano catastrófico, não antes, como em uma versão anterior do SB 1047.

\Por que Newsom pode vetá-lo

\Dada a forte oposição da indústria ao projeto de lei, não seria surpreendente se Newsom o vetasse. Ele estaria apostando sua reputação no SB 1047 se o assinar, mas se vetar, poderia adiar a decisão por mais um ano ou deixar que o Congresso lidasse com isso.

\"Isto [SB 1047] muda o precedente com o qual lidamos com a política de software nos últimos 30 anos," argumentou o sócio-gerente da Andreessen Horowitz, Martin Casado, em uma entrevista ao TechCrunch. "Isso transfere a responsabilidade das aplicações para a infraestrutura, o que nunca fizemos."\

A indústria de tecnologia respondeu com um forte clamor contra o SB 1047. Ao lado da a16z, a presidente Nancy Pelosi, a OpenAI, grupos comerciais de Big Tech e pesquisadores de IA de destaque também estão pedindo a Newsom para não assinar o projeto de lei. Eles estão preocupados que essa mudança de paradigma na responsabilidade tenha um efeito inibidor na inovação de IA da Califórnia.

\Um efeito inibidor na economia de startups é a última coisa que alguém deseja. O auge da IA tem sido um grande estimulante para a economia americana, e Newsom enfrenta pressão para não desperdiçar isso. Até mesmo a Câmara de Comércio dos Estados Unidos pediu a Newsom que vetasse o projeto de lei, dizendo que "a IA é fundamental para o crescimento econômico da América," em uma carta a ele.

\Se o SB 1047 se tornar lei

\Se Newsom assinar o projeto de lei, nada acontecerá no primeiro dia, disse uma fonte envolvida na redação do SB 1047 ao TechCrunch.

\Até 1º de janeiro de 2025, as empresas de tecnologia precisariam escrever relatórios de segurança para seus modelos de IA. Nesse ponto, o procurador-geral da Califórnia poderia solicitar uma ordem injuntiva, exigindo que uma empresa de IA pare de treinar ou operar seus modelos de IA se um tribunal os considerar perigosos.

\Em 2026, mais partes do projeto de lei entrariam em vigor. Nesse momento, o Conselho dos Modelos de Fronteira seria criado e começaria a coletar relatórios de segurança de empresas de tecnologia. O conselho de nove pessoas, selecionado pelo governador e legislativo da Califórnia, faria recomendações ao procurador-geral da Califórnia sobre quais empresas estão em conformidade ou não.

\No mesmo ano, o SB 1047 também exigiria que os desenvolvedores de modelos de IA contratassem auditores para avaliar suas práticas de segurança, efetivamente criando uma nova indústria de conformidade de segurança de IA. E o procurador-geral da Califórnia poderia começar a processar desenvolvedores de modelos de IA se suas ferramentas fossem usadas em eventos catastróficos.

\Até 2027, o Conselho dos Modelos de Fronteira poderia começar a emitir orientações aos desenvolvedores de modelos de IA sobre como treinar e operar seus modelos de IA com segurança e eficácia.

\Se o SB 1047 for vetado

\Se Newsom vetar o SB 1047, os desejos da OpenAI se tornariam realidade, e regulações federais provavelmente assumiriam a liderança na regulamentação de modelos de IA... eventualmente.

\Nesta quinta-feira, a OpenAI e a Anthropic lançaram as bases do que seria a regulamentação federal de IA. Elas concordaram em dar ao Instituto de Segurança de IA, um órgão federal, acesso antecipado aos seus modelos avançados de IA, de acordo com um comunicado à imprensa. Ao mesmo tempo, a OpenAI endossou um projeto de lei que permitiria ao Instituto de Segurança de IA estabelecer padrões para modelos de IA.

\"Por muitas razões, achamos importante que isso aconteça em nível nacional," escreveu o CEO da OpenAI, Sam Altman, em um tweet na quinta-feira.

\Lendo nas entrelinhas, as agências federais normalmente produzem regulações de tecnologia menos onerosas do que a Califórnia e levam consideravelmente mais tempo para fazê-lo. Mas mais do que isso, o Vale do Silício historicamente tem sido um importante parceiro tático e comercial para o governo dos Estados Unidos.

\"Há realmente uma longa história de sistemas de computadores de ponta trabalhando com os federais," disse Casado. "Quando eu trabalhei nos laboratórios nacionais, toda vez que um novo supercomputador era lançado, a primeira versão iria para o governo. Nós fazíamos isso para que o governo tivesse capacidades, e acho que essa é uma razão melhor do que para testes de segurança."\